Die Google Search Console meldet: durch robots.txt-datei blockiert. So löst du das Problem.

Durch robots.txt-Datei blockiert – So löst du das Problem

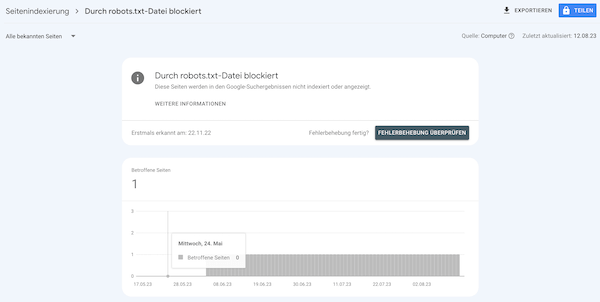

Die Suchkonsole ist eine der wichtigsten Google Tools für deine Website. Einige Seiten oder Verzeichnisse verursachen möglicherweise technische Probleme bei der Google Indexierung. Wenn du die Google Search Console eingerichtet hast, führt diese im Bericht Seitenindexierung mögliche Probleme auf. Zu sehen ist, wann Google das Problem zum ersten Mal festgestellt hat und für wie viele Seiten das zutrifft. Die betroffenen Seiten werden weiter unten aufgelistet.

Die Google Search Console meldet: durch robots.txt-datei blockiert.

Die robots.txt ist für die Steuerung des Bots, und damit die Google Indexierung, nötig. Hierüber erlaubst du dem Crawler, welche Verzeichnisse oder (Unter)Seiten, der GoogleBot scannen darf und welche nicht. Stehen in der robots.txt-Datei Ordner oder Seiten mit dem Disallow-Befehl, so verbietest du dem Bot diese zu durchsuchen. So z.B. im Fall Seite ohne Inhalt indexiert.

Der Crawler geht aber erstmal davon aus, dass er alles durchforsten darf. Erst im nächsten Schritt wird entschieden, was in den Suchindex darf. Werden vorher, durch die robots.txt aber schon bestimmte Dinge ausgeschlossen, meldet die Search Console Durch robots.txt-Datei blockiert.

Um das Problem Durch robots.txt-Datei blockiert zu beheben, rufst du die robots.txt auf. Diese liegt immer im Stammverzeichnis, also z.B. https://www.deineseite.de/robots.txt.

Prüfe die Datei, ob darin Seiten oder Ordner aufgeführt werden, auf die der Crawler nicht zugreifen soll. Die Standard-robots.txt für WordPress z.B. enthält nur:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Sitemap: https://www.deineseite.de/sitemap.xml

Lösche alles andere, was den GoogleBot beim Crawlen behindern könnte.

Sollen einzelne Unterseiten nicht in der Suchmaschine auftauchen, sollten diese besser per Noindex ausgeschlossen werden. Früher war es noch möglich, Seiten über die robots.txt von der Indexierung auszuschließen. Davon ist Google aber mittlerweile abgewichen.

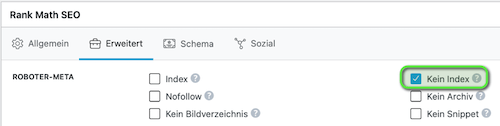

In RankMath z.B. kannst du das im jeweiligen Beitrag einstellen. Setze dazu im Reiter Erweitert den Haken bei Kein Index.

Gleiches gilt für die Bilddaten. Sollen Bilder nicht in den Suchergebnissen erscheinen, schreibe den Uploads-Ordner NICHT in die robots.txt. Sondern nutze hierfür wieder die Funktion in RankMath. Gehe dazu in WordPress auf Medien. Wähle das entsprechende Bild aus und klicke ganz unten auf Weitere Details bearbeiten. Unter dem Bild siehst du wieder das Menü von RankMath. Markiere das Häkchen bei Kein Index.

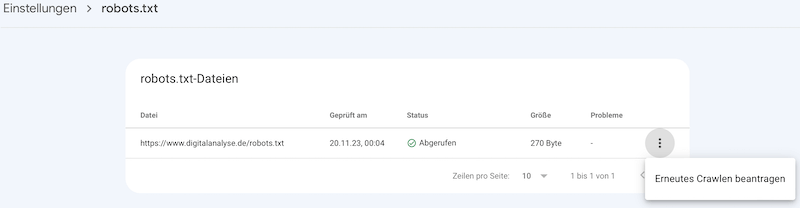

Problem gefunden? Dann lade die überarbeitete Datei auf den Server in das Stammverzeichnis. Reiche danach die neue Datei in der Google Search Console ein. Gehe dazu auf Einstellungen, in der Mitte bei robots.txt ganz rechts auf Bericht öffnen.

Klicke auf das 3-Punkt-Menü ganz rechts, um die robots.txt erneut zu crawlen.

Wechsle anschließend zurück in die Search Console, in den Bericht Seitenindexierung. Klicke dann auf Fehlerbehebung überprüfen.

![]()

Weitere Infos zum Aufbau der robots.txt gibt es von Google auf den Hilfeseiten. Wie die robots.txt funktioniert, dass beschreibt luna-park sehr gut. Noindex oder robots.txt? Dazu gibt es von SEO-Südwest einen guten Artikel.